opera 正在将对 150 种本地 (大型语言模型)变体的支持集成到 opera one(该公司的 ai 集成浏览器)的开发人员流中。添加对 ai 的实验性本地支持是浏览器的第一次,并允许直接从浏览器本身轻松访问 ai 模型。

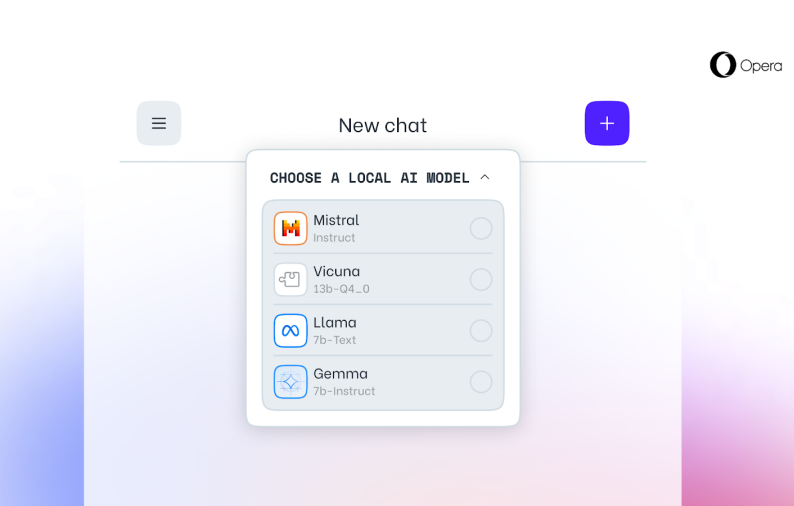

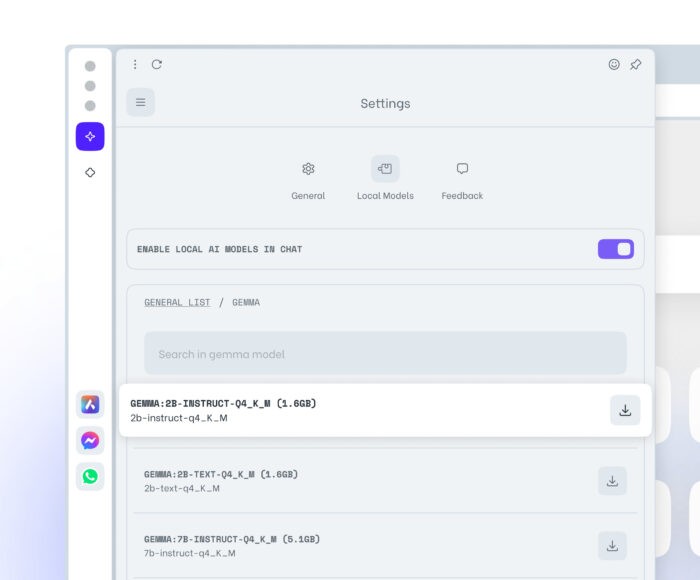

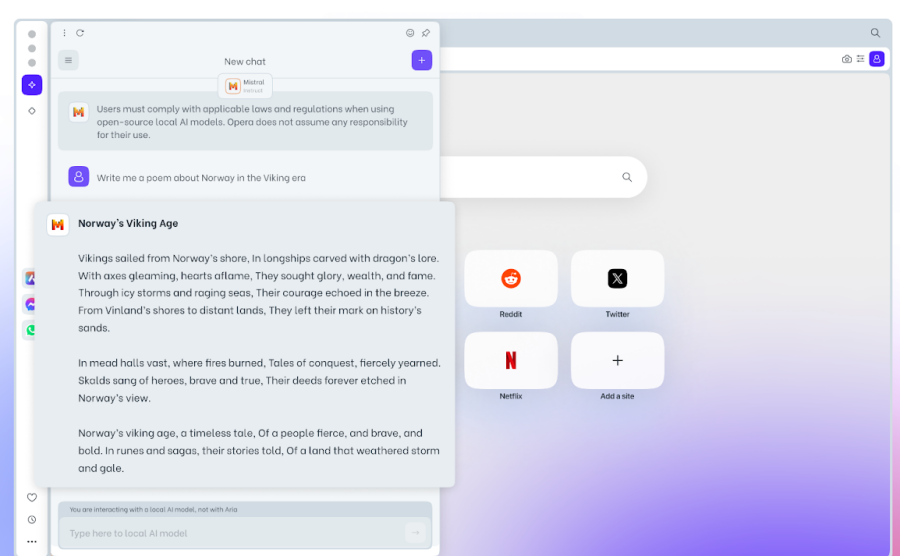

opera one 中一些比较突出的本地 llm 包括 meta 的 llama、google 的 gemma、vicuna 和 mistral ai 的 mistral 等。这些是 opera 自己的 aria 聊天机器人的补充。

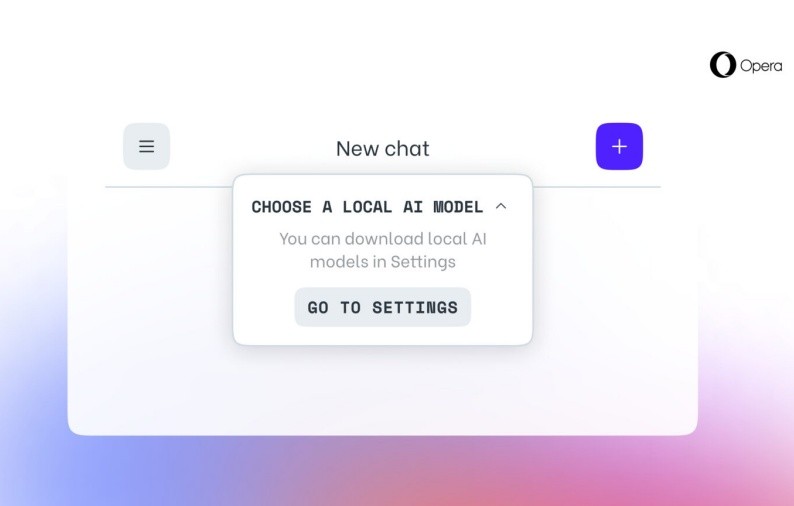

opera one developer 用户可以先更新到最新的浏览器版本,然后选择他们想要测试的模型,激活新功能,然后将本地 llm 下载到他们的机器上。典型的 llm 需要 2 到 10 gb 的存储空间。下载后,您将能够切换到并使用本地 llm 而不是 aria。请参阅我们的指南 如何在 opera one developer 上启用和使用本地 ai 模型以了解更多信息。

本地 llm 有几个好处,例如更好的隐私和安全性,因为数据不会离开您的计算机、离线使用以及整体上增强的浏览器体验。本地 llm 可能存在的一个缺点是,与基于服务器的 llm 相比,它在提供输出方面可能很慢,因为处理完全依赖于计算机的硬件功能。因此,即使它适用于大多数现代机器,但较旧的设备可能会感到资源紧张。

尽管如此,将本地 ai 模型集成到浏览器本身是 opera 向前迈出的一大步,我们可能会看到这成为其他主要浏览器的趋势。

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun293585.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重